Prueba ‘Riffusion’, un modelo de IA que compone música visualizándola • TechCrunch

6 min readLa música generada por IA ya es un concepto bastante innovadorpero Riffusion lo lleva a otro nivel con un enfoque inteligente y extraño que produce música extraña y cautivadora utilizando no audio sino fotos Sonido.

Parece extraño, es extraño. Pero si funciona, funciona. Y funciona ! Tipo de.

La difusión es una técnica de aprendizaje automático para generar imágenes que ha sobrealimentado el mundo de la IA durante el último año. DALL-E 2 y Stable Diffusion son los dos modelos más destacados que funcionan al reemplazar gradualmente el ruido visual con lo que la IA cree que debería ser un aviso.

El método ha demostrado ser poderoso en muchos contextos y es muy susceptible de refinamiento, donde le das al modelo más entrenado mucho de un tipo de contenido específico para especializarlo en la producción de más ejemplos de ese contenido. Por ejemplo, puede perfeccionarlo en acuarelas o fotos de automóviles, y será más capaz de reproducir cualquiera de esas cosas.

Lo que hicieron Seth Forsgren y Hayk Martiros para su proyecto amateur Riffusion fue refinar la dispersión estable en los espectrogramas.

“Hayk y yo tocamos juntos en una pequeña banda, y comenzamos el proyecto solo porque amamos la música y no estábamos seguros de si sería posible que una transmisión estable creara una imagen de espectrograma con suficiente fidelidad para convertirla en audio. “, dijo Forsgren a TechCrunch. “Cada paso en el camino, nos ha impresionado más y más con lo que es posible, y una idea lleva a la siguiente”.

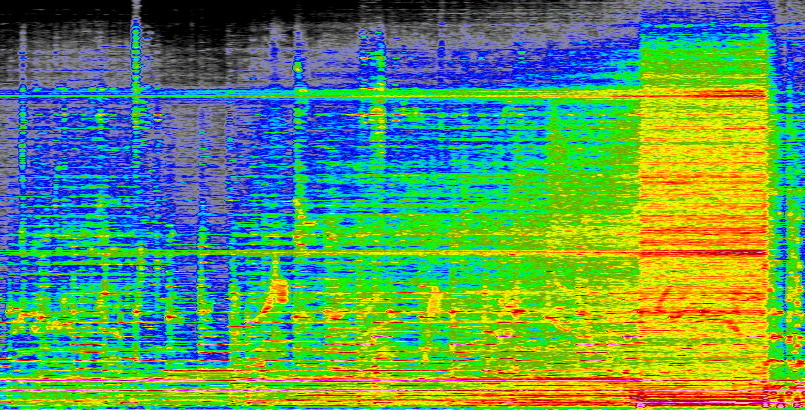

¿Qué son los espectrogramas, preguntas? Son representaciones visuales de audio que muestran la amplitud de diferentes frecuencias a lo largo del tiempo. Probablemente haya visto formas de onda, que muestran el volumen a lo largo del tiempo y hacen que el audio parezca una serie de colinas y valles; imagina si en lugar del volumen total, mostrara el volumen de cada frecuencia, de bajo a alto.

Aquí hay parte de la que hice yo mismo a partir de una canción (“La radio de Marconi” de The Secret Machinessi te lo preguntas):

Créditos de la imagen: Devin Coldwey

Puede ver cómo se vuelve más fuerte en todas las frecuencias a medida que se desarrolla la canción, e incluso puede detectar notas e instrumentos individuales si sabe qué buscar. El proceso no es intrínsecamente perfecto ni sin pérdidas, pero es una representación precisa y sistemática del sonido. Y puede volver a convertirlo en sonido realizando el mismo proceso a la inversa.

Forsgren y Martiros hicieron espectrogramas de un montón de música y etiquetaron las imágenes resultantes con términos relevantes, como guitarra de blues, piano de jazz, afrobeat, cosas así. Alimentar al modelo con esta colección le dio una buena idea de cómo “sonaban” ciertos sonidos y cómo podía recrearlos o combinarlos.

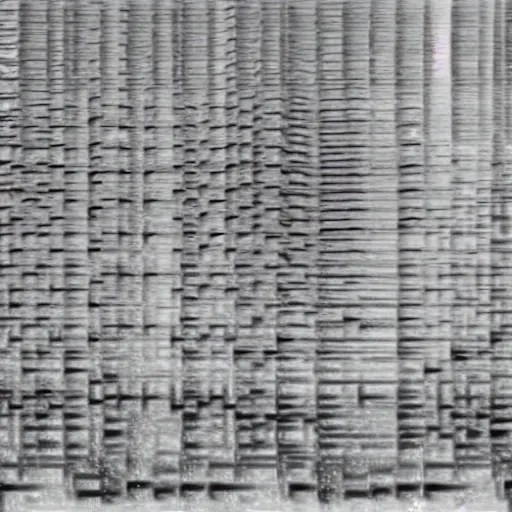

Así es como se ve el proceso de difusión si lo muestrea mientras refina la imagen:

Créditos de la imagen: Seth Forsgren / Hayk Martiros

Y, de hecho, el modelo ha demostrado ser capaz de producir espectrogramas que, cuando se convierten en sonido, coinciden bastante bien con indicaciones como piano funky, saxo jazz y similares. Aquí un ejemplo :

Créditos de la imagen: Seth Forsgren / Hayk Martiros

Pero, por supuesto, un espectrograma cuadrado (512 × 512 píxeles, una resolución estándar de transmisión estable) representa solo un clip corto; una canción de 3 minutos sería un rectángulo mucho, mucho más grande. Nadie quiere escuchar música durante cinco segundos a la vez, pero las limitaciones del sistema que habían creado significaban que no podían crear un espectrograma de 512 píxeles de alto y 10 000 de ancho.

Después de probar algunas cosas, aprovecharon la estructura fundamental de modelos grandes como Stable Diffusion, que tienen mucho “espacio latente”. Es un poco como tierra de nadie entre nodos más bien definidos. Por ejemplo, si tuvieras un área del modelo que representa a los gatos y otra que representa a los perros, lo que está “entre” ellos es un espacio latente que, si solo le dices a la IA que dibuje, sería una especie de perro gato. o gato, incluso si no existe tal cosa.

De paso, las cosas del espacio latente se vuelven mucho más raras que eso:

Sin embargo, no hay mundos espeluznantes de pesadilla para Project Riffusion. En cambio, descubrieron que si tiene dos mensajes, como “campanas de iglesia” y “ritmos electrónicos”, puede cambiar entre ellos poco a poco y eso está bien. el mismo ritmo:

Es un sonido extraño e interesante, aunque obviamente no particularmente complejo o de alta fidelidad; recuerda, ni siquiera estaban seguros de si los modelos de transmisión podrían hacer eso, por lo que la facilidad con la que este convierte campanas en ritmos o toques de máquina de escribir en piano y bajo es bastante notable.

Es posible producir clips más largos, pero sigue siendo teórico:

“Realmente no intentamos crear una canción clásica de 3 minutos con coros y versos repetidos”, dijo Forsgren. “Creo que se podría hacer con algunos trucos ingeniosos, como construir un modelo de nivel superior para la estructura de la canción y luego usar el modelo de nivel inferior para los clips individuales. Alternativamente, puede entrenar nuestro modelo en profundidad con imágenes de canciones completas con una resolución mucho mayor.

¿Adónde va desde aquí? Otras bandas intentan crear música generada por IA de varias maneras, usando modelos de texto a voz a audios especialmente entrenados como transmisión de baile.

Riffusion es más una demostración de “wow, échale un vistazo” que un gran plan para reinventar la música, y Forsgren dijo que él y Martiros están felices de ver a la gente participar en su trabajo, divertirse y ensayar:

“Hay muchas direcciones que podríamos tomar a partir de aquí, y estamos emocionados de seguir aprendiendo en el camino. Fue divertido ver a otras personas ya construyendo sus propias ideas en nuestro código esta mañana también. Una de las cosas sorprendentes de la comunidad de Stable Diffusion es la rapidez con la que las personas construyen sobre las cosas en direcciones que los autores originales no podían predecir.

Puede probarlo en una demostración en vivo en riffusion.com, pero es posible que tengas que esperar un poco para que tu clip se procese; recibió un poco más de atención de lo que esperaban los creadores. El código está todo disponible. a través de la página acerca deasí que siéntase libre de lanzar el suyo también, si tiene las fichas necesarias.

“Adicto a la televisión total. Experto en viajes. Gurú de Twitter. Evangelista de tocino. Creador galardonado. Aficionado al alcohol. Fanático de la música. Solucionador de problemas”.